SeaArtでは無料でComfyUIが使えますが、それだけではなくワークフローのテンプレートも用意されています。

これによってComfyUIにとっつきやすくなっているわけですが、ここ最近さらにテンプレートの種類が増え、より幅広い分野を試せるようになりました!

画像生成、動画生成、3Dモデル生成……ComfyUIでできることは大体そろっていて、変わり種のワークフローも存在し、非常に参考になるテンプレート集となっています。

今回は全てのテンプレートをどんな種類があるかなどサクサク紹介していきます!SeaArtの始め方やComfyUIの起動方法などはこちらの記事を参考にしてください。

Basic

t2iとかi2iとか、WebUIでやってきたこと、ComfyUIではどうなってる?を知るにはちょうどいいカテゴリ。初心者でなければ使う必要性は薄いです。

Image Generation

SD1.5のReV Animatedを使ったごくごく普通のt2i画像生成ワークフロー。

Image To Image

普通のi2i。画像を元に画像生成します。t2iと構成がほとんど変わらないと知るにはちょうどいいかも。

LoRA

t2iにLoRAがつきました。LoRAはDLCのようなもので、モデルが学習していない要素を描けるようになったり、品質を向上させたり無限の可能性を持ちます。

LoRA multiple

LoRAを複数使用。さっきのワークフローいらないんじゃ……

Inpaint

画像からマスクした部分に変化を加えるワークフロー。何もないところに新しく要素を足すのは苦手。たとえばおちんちんを生やしたかったら、元画像に形と色を足してやるとか。

でもInpaintよりAnytest使った方がいいですよね。加工しなくても脱がしたりできるので。

Outpaint

画像の外側を拡張して描いてくれるアウトペインティングワークフロー。インペイントばかり有名でアウトペイントを取り上げている記事は少ないので、覗いてみる価値はあるでしょう。

Only SeaArt

SeaArtのオリジナルツールがそろっているカテゴリー。Web上にあるものと同様で、スタミナ消費が絶対。

Flux

生成AIのFluxは、Black Forest Labsが開発した画像生成AIモデルです。

高品質でリアルな画像を生成することに優れ、特にプロンプトへの忠実性が高く、複雑な指示にも正確に対応できます。Schnell、Dev、Proの3つのモデルが存在。

Flux Dev Checkpoint Example

FLUX-Devモデルを使用し、高解像度の画像を生成します。Fluxとしては一番シンプルですがDevは所要利用不可なので注意しましょう。

基本的にエロ向きのモデルじゃないので、通常はヌードぐらいしかできません。しかしユーザーによってエロに強い派生LoRAなど続々と開発されており、実際はエロ利用できます。

それでも全体的に三次元寄りなので、実用性は今一つ。

Flux Schnell

一番軽いFlux Schnellモデルを使用、それ以外は先ほどと同じ。

Flux Inpaint

Flux版インペイント。InpaintModelConditioningノードを通じて、特定領域に対して効果的に処理を行う設計となっています。インペイント用のモデルがDevライセンスなので商用利用できません。

Flux Canny Model

画像を読み込んで、Cannyエッジ検出を適用して、線画から新しく画像を生成します。

Flux Depth Lora

こちらは奥行きに特化しています。

Image

画像生成のカテゴリー。大体そうだと思いますが。

HiDream I1

HiDream.aiが発表したHiDream l1モデルを使用した、t2iに基づいて画像を生成するワークフロー。

FLUX超えとも称されるHiDreamは、要求スペックが高すぎるのが問題でした。これがクラウドかつテンプレートからすぐ利用できるのはうれしいですね。

それでも多少の時間はかかってしまいますが。

anime art, completely nude girl lying on grass. semen on body.

一応脱ぎましたが、精液はちょっと違った感じ。エロ表現はそこまで得意じゃないか、検閲されてるかもしれません。

HiDream E1

HiDream I1のi2iバージョン。テンプレートでは1024×1024の画像を768に縮小させていたので、I1以上に要求が馬鹿にならないのでしょうね。

実際に筆者が試したところうまく生成できませんでしたし、超高性能なPCを手に入れてからローカルで出直したいところ。ワークフロー自体もダウンロードできますから。

SD3.5 Simple

Stability AIのStable Diffusion 3.5を利用したt2iワークフロー。性能は悪くないですが結局流行りませんでしたね。

SDXL Simple

こちらはSDXLバージョン。SD3.5よりも前ですが、かの有名なPony系モデルやIllustrious系モデルは元をたどればSDXL生まれ。今日の二次元AI画像を最も支えている存在といっても過言ではない!

SDXL Revision Text Prompts

2つの画像が影響を与えるワークフロー。なんとなく画像をフュージョンさせたいときにいいかも。

SDXL Revison Zero Positive

SDXL Revision Text Promptsと似ていますが、決定的な違いはConditioningZeroOutでプロンプトが渡され、ニュートラルなベースラインで画像を生成しようとしているようです。

こちらのほうが画像融合の影響を受けやすいように感じました。

SDXL Refiner Prompt

Refinerで微細な調整を行い、ベースモデルで生成された画像にさらなる磨きをかけるワークフロー。アップスケールなどと比べると影が薄いですが、使いこなせれば面白そうです。

SDXL Turbo

爆速で生成できるSDXL Turboを使ったワークフロー。ノードが他で流用できないし、クラウド環境なので使う必要なし。

Video

動画生成カテゴリー。Wan2.1とHunyuan Videoがテンプレートひとつで。特にWAN2.1はエロ動画を作るのに適しています。

工夫すればこんな感じの動画も簡単に作れますので、以下の記事も参考にしてください。

Wan 2.1 Text to Video

テキストから動画を生成するWan2.1のワークフロー。解像度は832×480ピクセル。

Wan 2.1 Image to Video

画像から動画を生成するWan2.1のワークフロー。解像度は512×512ピクセル。

Wan 2.1 Fun InP

こちらは開始フレームと終了フレームを指定できるワークフロー。面白いですが、最適な画像を見つけるのに結構苦労したりします。

Wan 2.1 Fun ControlNet

Cannyエッジ検出とWAN2.1モデルを組み合わせ、指定された動画のフレームを元に、より詳細な制御を伴う動画生成を実現しています。解像度は960×544ピクセル。

Wan 2.1 FLF2V

Wan 2.1 Fun ControlNetと比較して、より具体的な「開始フレームから終了フレームへの動画生成」に焦点を当てています。

これは、特化されたUNetモデル(wan2.1_flf2v_720p_14B_fp16)と専用の動画生成ノード(WanFirstLastFrameToVideo)の使用、および開始画像と終了画像の両方に対するCLIPVisionエンコードによって強調されています。

また、出力解像度が高くなり、動画フォーマットもMP4になりました。

LTXV Text to Video

LTXVでテキストから動画生成を行うワークフロー。初めて使いました。

スピードはありますが、アニメ系はてんでダメですね。

LTXV Image to Video

画像からLTXVで生成します。テキストよりは品質がいいです。

Hunyuan Video Text to Video

Hunyuan Videoで動画生成するワークフロー。FramepackもHunyuan Videoをベースにしています。

SVD Image to Video

Stable Video Diffusion (SVD)で画像から動画生成します。一瞬で終わるので、昔のAI動画はこんな感じだったなぁと懐かしむにはぴったり。

SVD Text to Image to Video

ここにきてテキストから動画生成のほうが後になったのは、画像からでも高速だ、ってことの裏付けでしょうか。

Upscaling

画像をアップスケールして品質や解像度を向上させるカテゴリー。

Upscale

テキストプロンプトから768ピクセルの画像を生成し、次にその画像をより高解像度にする「Hires Fix」で1152ピクセルにアップスケールします。

ESRGAN

RealESRGAN_x4plusを用いてアップスケールします。Upscale Image (using Model)ノードは画像を自動的に4倍でアップスケールするのですが、Upscale Image By (Using Model)ノードを使うと倍率を1ノードで調整できるのでオススメです。

HiresFix ESRGAN

UpscaleとESRGANテンプレートを組み合わせたようなワークフロー。デフォルトで生成される画像が怖い。

Latent Upscale Different Prompt Model

アップスケールしてから、モデルとプロンプトを変えて画像を味変するイメージ。

Control Net

Fluxテンプレートですでに登場しましたが、CannyやOpenPoseの技術を使用して画像生成するカテゴリー。通常SDXLでは使えません。

ControlNet

Cannyによるt2iワークフロー。デフォルトのネガティブプロンプトに(penis)があって面白い。

2Pass Pose Worship

OpenPose画像から人の姿勢を検出し画像を生成した後、ノイズを加えながらアップスケールするワークフロー。

1から作るのであればOpenPose Poseノードを使います。

Mixing ControlNets

2Pass Pose WorshipではすでにOpenPose処理後の画像がApply ControlNetに繋がっていましたが、こちらはまず普通の画像からOpenPose画像に変換。

その後ControlNet Scribbleとの合わせ技で画像生成します。

Area Composition

画像をエリア分けして描写するカテゴリー。

Area

画像をエリア分けして、それぞれ異なる要素を与えるワークフロー。ただしマスクは使ってません。

朝、昼、夕方、夜。それぞれのプロンプトは ConditioningSetAreaノードに接続され、特定座標における描写内容として設定されます。

Area Composition Reverse

Areaが逆転してるだけ。以上。

Area Composition Square Area For Subject

エリア分けが正方形になってノードも少なくなったので、直感的に理解しやすいエリアワークフロー。

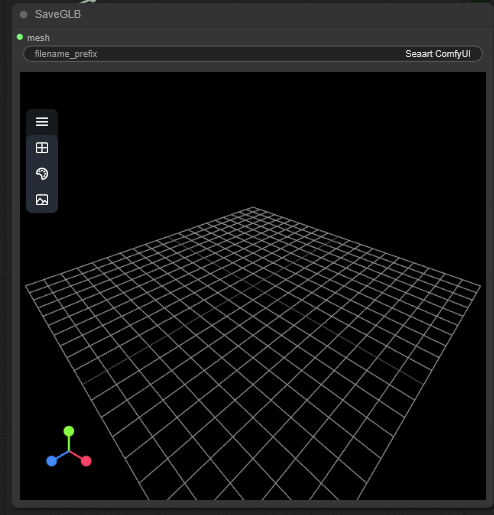

3D

3Dモデル生成。GLB形式で保存できてグリグリ動かせます。

Stable Zero123 Example

Stable Zero123による3D画像生成、というよりは異なるアングルを生成してくれるワークフロー。のはずなんですが頓珍漢な画像しか生成されず用途は一切不明。

Hunyuan 3D

Hunyuan Videoじゃない方。生成画像がマインクラフトのワールドか?ってくらいボクセルアートなのが問題。VoxelToMeshBasicノードをVoxelToMeshノードに変えれば、なめらかにできます。

こんなノード、今まで見たことない!

Hunyuan 3D multiview

複数の角度から画像を参照して、より再現性の高い3Dモデルを生成します。

Hunyuan 3D Turbo

スピード重視のワークフロー。Hunyuan 3D multiviewでは3方向からの画像だったのですが、こちらは正面と横だけあれば成立します。

丁度使えそうな画像があったのでやってみましたが、Turboにしては品質もそこまで劣化せず気軽に試せる3D生成ですね。

Audio

音声生成のカテゴリー。現在Stable Audioのみ。

Stable Audio

Stable Audioを利用して最大47秒の音声を生成できるワークフロー。曲調が変化したりは難しいので、ループ音楽としてなら有用です。効果音もいけます。

Hシーンでこんなの流れてほしくない。

Ace Step

Localで使えるSunoのようなもの。詳細はこちらの記事を参照。

まとめ

以上、SeaArtで利用できるComfyUIテンプレートを全種紹介しました。

「えっちな画像を量産したいけど、複雑なノード組みは無理……」という人にとって、テンプレートは強力な味方になります。

本記事を参考に、自分の性癖にぴったりなテンプレを見つけてみてください!SeaArtは無料なので、いつでも試せますよ。